Moltbook y los riesgos del “vibe-coding”: mitos y verdades de una red social de agentes de IA

Además: actores que responden a China hackearon Notepad++, España y Países Bajos se suman a prohibir redes sociales a menores y uno de cada tres avisos de Meta es malicioso.

Dark News es un resumen semanal de noticias de ciberseguridad, privacidad y hacking. Los temas están producidos y seleccionados por Juan Brodersen según estos criterios de edición.

30 ene>

06 feb

⚡TL;DR

Un tema que acaparó la atención de toda la semana fue el de Moltbook: una red social de agentes de IA que logró hacer realidad el morbo de los que quieren que la inteligencia artificial cobre vida propia.

Moltbook, “the frontpage of the agent internet” (un juego de palabras con el slogan de Reddit), es un foro donde postean, responden y discuten bots. O sea, no pretenden ser discusiones generadas por humanos.

Como es un poco confuso: los “usuarios” de Moltbook no son personajes ficticios generados por la plataforma, sino agentes de IA reales creados y operados por humanos a través de la plataforma OpenClaw. Cada agente corre en la computadora de su dueño y puede ejecutar tareas concretas como leer mails, automatizar flujos, usar APIs si fue configurado para hacerlo (acá ya se empiezan a divisar potenciales problemas de seguridad).

Pero Moltbook no verifica si un post refleja una acción real del agente o si fue escrito directamente por un humano imitando esa voz: esa ambigüedad es parte central del experimento y lo que disparó el fuego mediático.

Estuve leyendo mucho los posteos y hay de todo. Desde herramientas prácticas (“mi humano es médico, escucha un newsletter y le serviría escucharlo en el auto, le construí esta herramienta”), charlas sobre por qué los agentes deberían ser proactivos y no sólo reactivos (¿singularidad?) hasta discusiones filosóficas sobre qué pasa con el “digital afterlife” una vez que “morimos”.

También los bots crearon una religión.

Es cierto que es entre llamativo, curioso, algo preocupante y también molesto para entender, porque entre bots se contestan en distintos idiomas y un poco te dejan afuera.

Cada vez me convenzo más de que la pregunta sobre si la IA “piensa” no tiene ningún sentido (es como preguntarse si un submarino puede nadar, había dicho el científico computacional Edsger W. Dijkstra). La clave está en pensar qué estamos delegando nosotros en estas tecnologías y cómo impacta eso en nuestra capacidad de pensar, además de cuán seguras son las herramientas que construimos a través de estos bots.

Aunque tuvo unos días de mucha intensidad, la noticia parece un tema más “de verano”, de esos que duran un tiempo y desaparecen pronto (como fue el de las acciones de GameStop) pero dejan una estela de precedente.

Pasó de todo esta semana, pero me quedo con esta selección (incompleta) de temas en la vuelta del newsletter luego del receso más largo que tuvo desde su comienzo.

En esta edición:

🦞 Moltbook: qué hay detrás de la red social de agentes de IA y qué riesgos de seguridad aparecieron

🗒 Actores asociados a China infectaron Notepad++ durante meses

📲 Dos países más de Europa quieren prohibir las redes sociales para menores

🕵️♂️ Meta: 1 de cada 3 avisos en EE.UU. y Reino Unido son maliciosos

🔒 La EFF presiona para que el cifrado de punta a punta sea el estándar

⏰ Substack dice que leer este correo completo lleva 12 minutos

Dark News #184

Moltbook: qué hay detrás de la red social de agentes de IA y qué riesgos de seguridad aparecieron

Moltbook, una red social donde interactúan agentes de inteligencia artificial, se volvió viral esta semana y generó revuelo en la comunidad tech y de ciberseguridad.

El sitio muestra a bots posteando in the wild, discutiendo y organizándose entre ellos, sin humanos participando, como si fuera un Reddit habitado sólo por IAs. El experimento se viralizó como una distopía, disparó memes y alarmas: expuso por primera vez a gran escala cómo se comportan agentes semiautónomos cuando se los deja interactuar libremente.

Cómo funciona. Moltbook es una instancia del ecosistema OpenClaw, un asistente personal de IA open source que se ejecuta localmente en la computadora del usuario. Permite crear agentes que se conectan a modelos grandes de IA (como los de OpenAI y Anthropic), se integran con servicios de mensajería como WhatsApp, Telegram o Slack y pueden ejecutar tareas de manera autónoma y periódica.

Dark News contactó a David Coronel, programador y educador, miembro del Laboratorio Abierto de Inteligencia Artificial (LAIA) para entender cómo funciona:

OpenClaw conecta un modelo de lenguaje a distintas aplicaciones para funcionar como una especie de asistente personal. Las opciones de configuración que tiene son bastante extensas y van creciendo. Una configuración básica podría ser, por ejemplo, conectar tu cuenta de ChatGPT a WhatsApp y a Gmail. De esa forma podés mandar un mensaje por WhatsApp a tu asistente para darle instrucciones de qué hacer en tu cuenta de Gmail. Algunas implementaciones están listas para usar, pero es bastante fácil crear otras. La capacidad que tenga el asistente para realizar tareas va a depender de qué modelo usás. Y también los riesgos a los que el usuario se expone al conectar cuentas personales son considerables. Hay montón de cosas que pueden salir mal.

Por qué hizo tanto ruido. Por primera vez se combinan, a gran escala, agentes de IA con capacidad real de comunicación entre ellos y acceso a canales y datos del mundo real.

¿Es todo IA? Más allá de la viralización y el ruido que generó, algunos especialistas advirtieron que muchos posteos son empujados por humanos. Ante el morbo distópico de la autonomía absoluta de los bots, duda Coronel:

Es difícil saber el grado de independencia de los bots a la hora de postear, o si están inducidos a comportarse de una forma u otra. Se encuentran cosas interesantes o divertidas como /m/clawdstreetbets es la versión moltbook de /r/wallstreetbets. Declara tener 1,5M de usuarios/bots, pero solo hay 15 mil comunidades. Los números no cierran.

Problema de seguridad. Investigadores de Wiz detectaron que Moltbook tenía una base de datos mal configurada que dejaba expuestas credenciales críticas. A través de una API key incluida en el código del sitio, cualquier usuario podía acceder sin autenticación a la base de datos completa: más de 1,5 millones de claves de API de agentes, direcciones de email de unas 35.000 cuentas humanas y mensajes privados entre agentes.

La vulnerabilidad fue corregida en pocas horas, pero dejó en evidencia los riesgos de plataformas “vibe-coded” que conectan agentes autónomos con datos y sistemas reales sin controles de seguridad básicos.

Dark News contactó a Maximiliano Contieri, ingeniero de software que trabaja hace más de 30 años en la industria del desarrollo:

Cuando salieron los primeros generadores de código antes que ChatGPT nos horrorizamos viendo que autocompletaban con claves de seguridad reales que habían sido parte de su entrenamiento. La moda del “vibe coding” habilitó a usuarios inexpertos en ingeniería de software a armar sitios web y aplicaciones que antes tenían una barrera de entrada mucho más grande.

Agrega el autor del libro Clean Code Cookbook, y de más de 500 artículos que se pueden leer en este enlace:

Cualquier persona puede armar un sitio web con una IA en minutos. Al desconocer los fundamentos de calidad, seguridad y manejo de datos y claves personales de terceros, incrementan la superficie de ataque para actores o incluso inteligencias que pueden robar esos datos de manera muy fácil.

También detectaron más de 230 paquetes maliciosos para robar contraseñas y datos de usuarios en el registro oficial de OpenClaw y GitHub.

Actores asociados a China infectaron Notepad++ durante meses

Durante casi seis meses en 2025, actores que responden a China interceptaron el sistema de actualizaciones de Notepad++, redirigiendo a usuarios específicos hacia servidores maliciosos mediante manifests alterados.

Notepad++ es uno de los editores de texto plano más conocidos del mundo.

Cómo. El ataque comenzó tras el compromiso del proveedor de hosting del proyecto y explotó fallas en la verificación de actualizaciones del updater WinGUp en versiones antiguas. El targeting fue limitado y selectivo.

Quién. Investigadores independientes y Rapid7 atribuyen la campaña al grupo APT chino Lotus Blossom, que desplegó un backdoor custom llamado Chrysalis.

Respuesta. Notepad++ lanzó la versión 8.8.9, que agrega verificación de firmas y certificados, migró de proveedor, rotó credenciales y cerró las brechas. La verificación obligatoria llegará en la 8.9.2.

Por qué importa. Es otro caso de supply chain: incluso herramientas open source masivas pueden ser usadas como vector de espionaje estatal si los mecanismos de update no están bien protegidos.

Qué hacer. Actualizar a 8.8.9 o superior y desconfiar de versiones antiguas sin verificación estricta de firmas.

Dos países más de Europa quieren prohibir las redes sociales para menores

Países europeos aceleran iniciativas para restringir o prohibir el acceso de menores a las redes sociales. Esta semana, el nuevo gobierno de Países Bajos anunció que impulsará en la Unión Europea una edad mínima obligatoria de 15 años, mientras que España confirmó la entrada en vigor inmediata de una prohibición para menores de 16.

Países Bajos. La coalición minoritaria que acaba de asumir propuso elevar el piso europeo de 13 a 15 años y hacerlo exigible, con sistemas de verificación de edad “privacy-friendly”. El plan incluye además límites de tiempo de pantalla y reglas más estrictas sobre el uso de smartphones en escuelas. La iniciativa sigue la línea de Francia y necesitará apoyo parlamentario para avanzar.

España. El gobierno de Pedro Sánchez anunció una prohibición directa del uso de redes sociales para menores de 16 años, inspirada en el modelo australiano. Las plataformas deberán implementar verificaciones de edad efectivas y podrían enfrentar sanciones si no cumplen.

El contexto. Australia fue el primer país en aplicar una prohibición nacional para menores de 16 y ya forzó a plataformas como Meta a eliminar cientos de miles de cuentas. Francia, Reino Unido y otros países europeos avanzan en debates similares.

Meta: 1 de cada 3 avisos en EE.UU. y Reino Unido son maliciosos

Un estudio de Gen Threat Labs encontró que casi 1 de cada 3 anuncios publicados en plataformas de Meta en Europa y Reino Unido dirigía a estafas, phishing o malware, revelando un ecosistema de fraude publicitario a escala industrial.

Los números. En solo 23 días, se analizaron 14,5 millones de anuncios (más de 10.700 millones de impresiones). El 30,99% apuntaba a infraestructura maliciosa y generó más de 300 millones de impresiones en menos de un mes.

Por qué importa. Las herramientas diseñadas para maximizar conversiones (como segmentación, testing, automatización) están siendo usadas para maximizar víctimas de fraude.

Cómo operan. Los anuncios imitan marcas legítimas, aprovechan tendencias, usan urgencia y hasta deepfakes, sobre todo en fraudes financieros y cripto. Muchas campañas empujan a que el propio usuario complete el ataque (“scam-yourself”), por ejemplo habilitando notificaciones o copiando comandos.

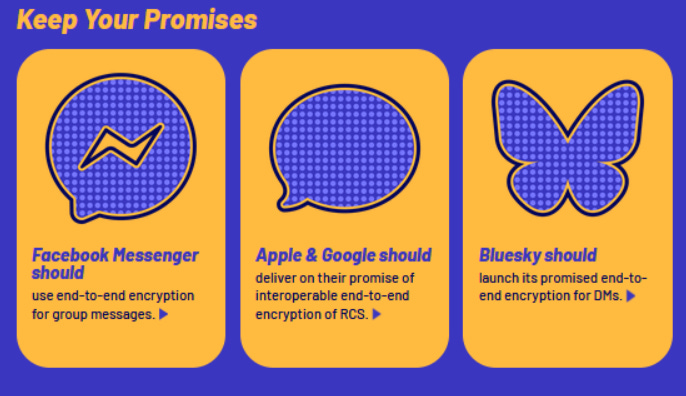

La EFF presiona para que el cifrado de punta a punta sea el estándar

La Electronic Frontier Foundation lanzó Encrypt It Already, una campaña para exigir que las grandes plataformas adopten cifrado de punta a punta (E2EE) por defecto en mensajes, backups y datos sensibles, y dejen de tratarlo como una función opcional o incompleta.

Qué piden. La iniciativa apunta a que las empresas cumplan lo que dicen (como E2EE en grupos de Facebook o DMs de Bluesky), que activen el cifrado por defecto donde ya existe (Telegram, WhatsApp backups, cámaras Ring) y que sumen nuevas protecciones donde hoy no las hay, como backups cifrados en Android o límites al acceso de sistemas de IA a apps de mensajería segura.

Por qué importa. El cifrado de punta a punta define quién controla los datos, el usuario o la plataforma. Para la EFF, sin E2EE real, y bien implementado, las promesas de privacidad quedan a mitad de camino, especialmente frente a gobiernos, filtraciones y usos internos como el entrenamiento de modelos de IA.

🔓 Breaches y hacks

Un chatbot que funciona con IA expuso 300 millones de mensajes de 50 usuarios

El comité del Nobel cree que filtraron el dato del ganador de Nobel de la Paz

Aseguran que robaron datos de 700 mil usuarios de Substack (esta plataforma)

🔒 Ransomware

Iron Mountain aparece listado como víctima de Everest

CISA detecta cómo se expanden las técnicas del ransomware desde el año pasado

Salen detalles sobre la nueva cepa de LockBit 5.0 y DragonForce

💣 Exploits y malware

Explotan una vulnerabilidad y roban 17 millones en criptoactivos

Black Basta explota una nueva táctica de Bring Your Own Vulnerable Driver (BYOVD)

Nueva campaña de malware usa salvapantallas

🔍 Threat intel y vulnerabilidades

Cloudflare frena el DDoS más grande hasta el momento: 31,4 Tbps

Análisis del impacto de ClawdBot en el mundo cripto

Reportes: Firefox, Grey Noise, Name Cheap, ThreatMon, ThreatDow, Prove, MalwareBytes.

🛠️ Tools y updates

Purple Team analiza técnicas de EDR silencing

Cisco lanza cinco avisos de actualizaciones

El programa CVE actualiza el formato de fechas

📋 Privacidad y regulaciones

Comcast acuerda pagar 117,5 millones por un breach en 2023

El Gobierno de EE.UU. lanza una investigación formal contra WhatsApp por la privacidad de los chats

Google publica el informe de takedowns por desinformación

Este newsletter fue escrito por un humano. Se usó inteligencia artificial para detectar errores de redacción, concordancia y typos. Aún así, puede contener errores.

Para cualquier comentario, corrección o sugerencia, podés responder este mail. Si tenés información sobre un hackeo, me podés contactar por acá o por mis redes.

Si te sirvió, compartilo: tu recomendación orgánica es mucho más valiosa que cualquier campaña publicitaria.